株式会社ユー・エス・エス/上田写真製版所 ブログ

◆M4 Mac miniでローカルLLM活用への第一歩

ハードウェア刷新による環境改善

これまで使用しておりましたMac miniは2018年モデルであり、動作の重さやOSアップデート対象外となる可能性が高まったことから、この度、M4チップ搭載のMac miniへ刷新いたしました。

旧環境では、ローカルでのLLM(大規模言語モデル)実行はスペック不足のため実用レベルにありませんでした。しかし、今回の機器更新により、大規模モデルこそ難しいものの、約30GB程度の中規模LLMを動作させることが可能となりました。

現在、Mac上でLLMを動かすアプリケーションとしては「Ollama」と「LM Studio」を導入しておりますが、直近ではLM Studioを主に使用しています。

ローカルLLM活用の最大のメリット:セキュリティの確保

ChatGPTやGeminiなどのブラウザ経由で利用するLLMは、入力内容が外部サーバーで処理されるため、内部情報や個人情報などの機密データが外部に漏洩するリスクを完全には否定できません。この懸念から、LLMの利便性を享受しつつも、業務での利用には慎重にならざるを得ないのが現状です。

一方で、ローカルマシンで動作するLLMは、入力データが外部へ送信されることなく、内部で完結して処理されます。これにより、情報漏洩のリスクを抑え、機密性の高い業務においてもLLMを安心して活用することが可能になります。

ローカルLLM利用時の留意点:性能と限界

業務利用が可能になったとはいえ、ローカルで動作させる比較的小規模なモデルには、ハルシネーション(誤情報生成)の問題が付きまといます。

例えば、テキストの体裁を整えるためにLLMを利用した場合、意図しないテキストの置き換えが発生する可能性があります。一見同じに見えても、重要な情報が書き換わっている可能性があるため、出力結果をそのまま採用することにはリスクが伴います。確実性を求める作業においては、最終的な全文チェックは人の手で行う方が確実でしょう。

また、「変更箇所の校正もLLMに任せれば良い」という考え方もありますが、現行のローカルモデルの校正能力には限界があります。明らかな誤りを見落とすケースも散見され、実務で信頼性の高い校正ツールとして用いるには、性能面で課題が残るのが現状です。

外部に公開可能な情報であれば、GeminiやChatGPTといった高性能な外部LLMの方が圧倒的に優れています。ローカルモデルは性能に制約があるため、その活用場面は限定的であることを理解しておく必要があります。

画像認識モデルの活用可能性

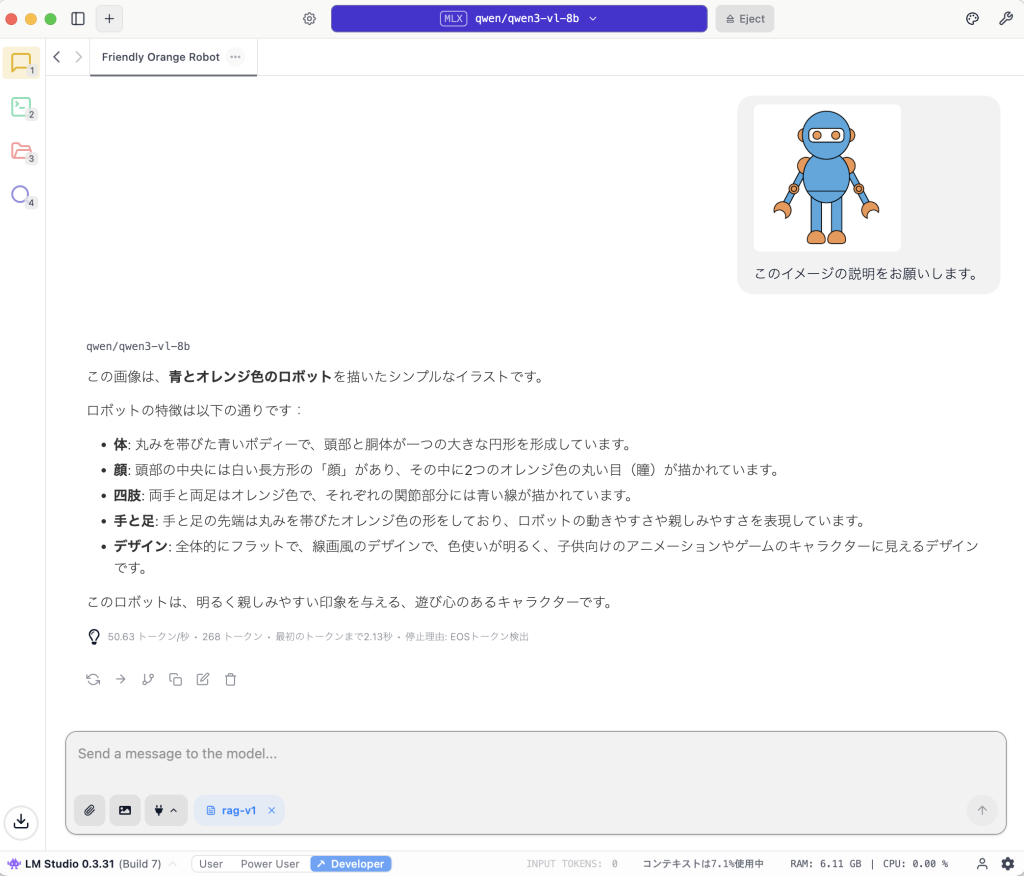

LM Studioでは、画像認識モデルも利用できます。こちらもローカルで処理が完結するため、機密性の高い画像データも安心して活用できます。

試験的に、「qwen3-vl-8b」という比較的軽量なモデルを使用し、イラストの説明を依頼してみました。8bという小規模なモデルながら、イラストの表現を的確に言語化する結果を得られました。

デザイン業務においては、抽象的な表現を言語化する必要が生じるケースが多々あります。このような場面で、AIによる客観的な判断を参考に加えることは、表現の幅を広げる一助となるでしょう。

さらに、写真の解析によるデータベース用のタグ生成など、画像データベースの作成・整備への応用も期待できます。

今後の展望:実務に活きるツールの見極め

ChatGPTやローカルLLMなど、利用可能なツールは増加の一途を辿っています。ここで重要なのは、「どのように活用するか」です。ツールの導入が実際の業務効率向上に結びつかなければ、その活用は定着しません。

株式会社ユー・エス・エスでは、今後も、単なる技術検証に留まらず、実務に活かせる具体的な活用シーンを見極めながら、積極的に導入を進めてまいります。